De Uitdaging

Het klantenserviceteam werd overspoeld met een groot volume aan repetitieve vragen. Dit leidde tot lange wachttijden voor klanten en een hoge werkdruk voor medewerkers. De bestaande informatie was verspreid over een uitgebreide interne kennisbank (PDF's, handleidingen, FAQ's), wat het voor medewerkers soms lastig maakte om snel het juiste antwoord te vinden. De uitdaging was om een schaalbare oplossing te creëren die 24/7 directe en accurate antwoorden kon geven.

Mijn Aanpak

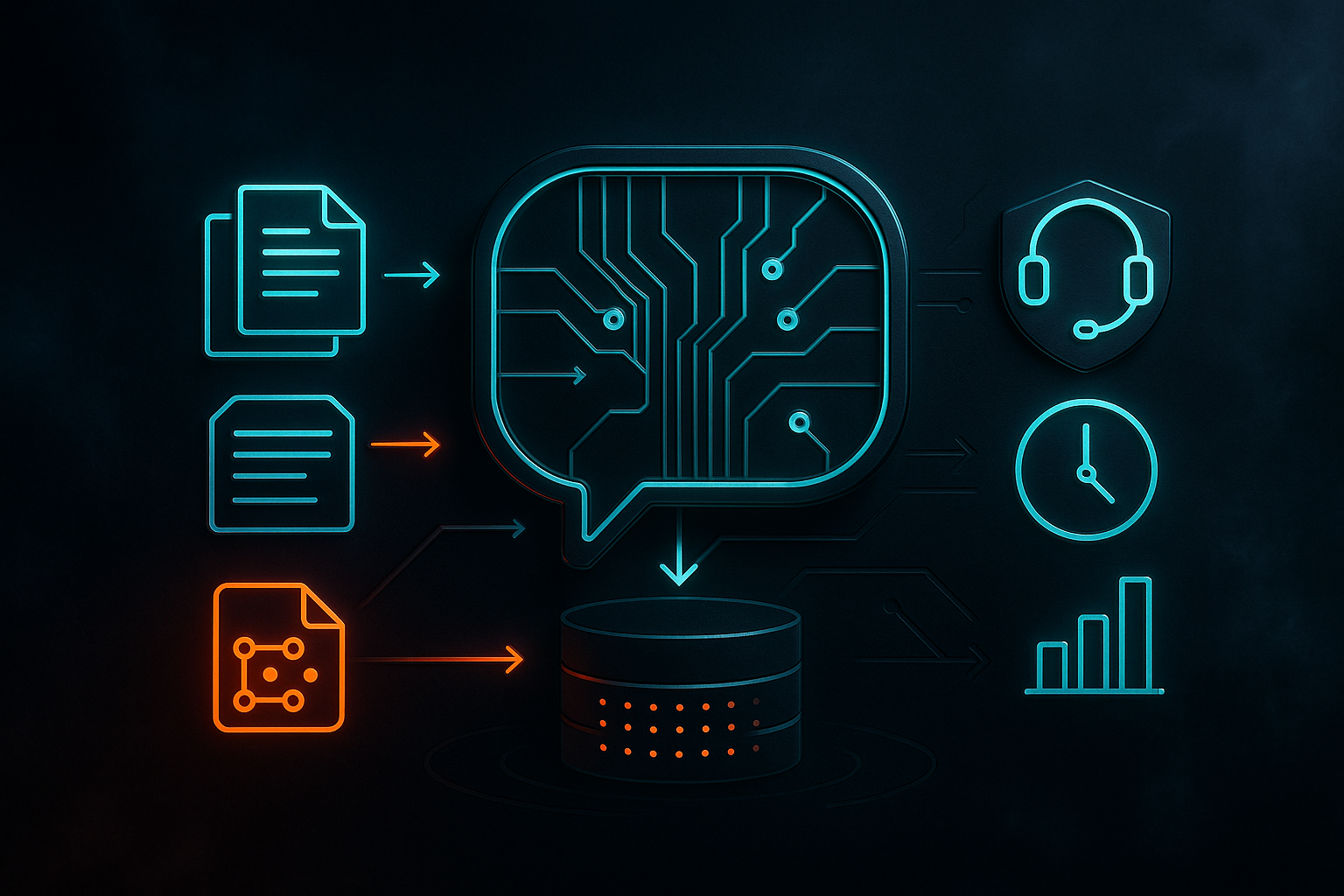

Voor dit project heb ik gekozen voor een Retrieval-Augmented Generation (RAG) architectuur. Deze aanpak combineert de kracht van een Large Language Model (LLM) met een betrouwbare kennisbron, wat 'hallucinaties' (het verzinnen van foute informatie) voorkomt.

- Kennisbank Voorbereiden: Eerst heb ik alle relevante documenten uit de kennisbank verzameld en opgeschoond. Vervolgens zijn deze documenten opgesplitst in behapbare stukken en omgezet naar 'embeddings' (numerieke representaties), die zijn opgeslagen in een vector database.

- Retrieval Systeem: Wanneer een gebruiker een vraag stelt, zoekt het systeem in de vector database naar de meest relevante tekstfragmenten die met de vraag overeenkomen.

- Generatie met Context: Deze gevonden fragmenten worden vervolgens als context meegegeven aan een LLM (zoals een model van OpenAI of een open-source alternatief). Het LLM krijgt de expliciete instructie om de vraag alléén te beantwoorden op basis van de verstrekte context.

- Implementatie & Integratie: Met behulp van Python en het LangChain-framework heb ik de volledige RAG-pijplijn gebouwd en geïntegreerd in de bestaande systemen van de klant.

Het Resultaat

De geïmplementeerde RAG-chatbot was een groot succes. Binnen enkele weken handelde de bot meer dan 40% van alle binnenkomende klantvragen zelfstandig af. Dit resulteerde in een aanzienlijke verlaging van de werkdruk op het serviceteam, waardoor zij zich konden richten op complexere klantproblemen. De wachttijden voor klanten werden korter en de consistentie van de antwoorden verbeterde significant, wat leidde tot een hogere klanttevredenheid.